Transfer Learning 전이학습

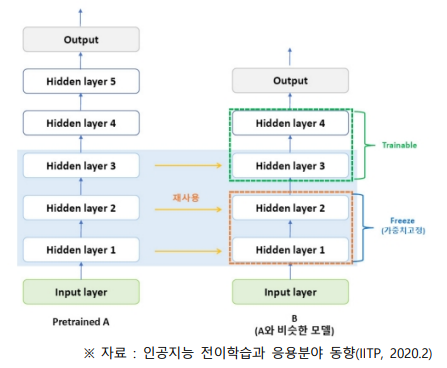

전이학습은 특정 태스크를 학습한 모델을 다른 태스크 수행에 재사용하는 기법이며, 아래 그림에서 Task2를 배울 때, Task1에서 수행했던 지식을 재활용

- Task1을 업스트림(Upstream) 태스크라 부르고, Task2는 이와 반대되는 의미로 다운스트림(Downstream) 태스크라고 부름

- 언어모델들은 Task1에서 일반적인 언어에 대한 이해를 지향하고 있으며,Task2에서 번역, 요약, 질의응답 등 구체적 태스크를 수행

- 업스트림 태스크를 학습하는 과정을 사전학습(Pretraining)이라 표현하고, 사전학습 모델(Task1 해결 모델)을 전이학습한 모델로 Task2 수행

[초대규모 AI 모델(GPT-3)의 부상과 대응 방안(2021), NIA]

1. 모델 전체 업데이트

2. 모델의 일부 동결(Freezing)

3. 전체 모델 동결, 추가로 쌓은 Layer만 훈련

Discussion